Softmax

- 한 벡터가 어떤 class에 속할지 확률 예측

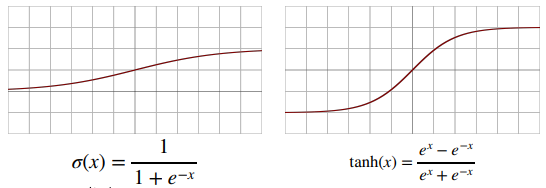

Activation Function

- nonlinear function

- 활성 함수 + 선형모델 = 신경망

forward propagation(순전파)

output

activation func(z)

z = weight * data + bias

input data

- layer가 많을수록 필요한 뉴런(node)의 수가 줄어 효율적인 학습 가능

- 그러나, 최적화가 어려워질 수 있음

backward propagation(역전파)

- 각 노드의 tensor 값을 저장해야 미분이 가능하므로 순전파보다 느림(위 식에서 x,y를 모두 기억해야 함)

'부스트캠프 AI Tech > Math' 카테고리의 다른 글

| Statistics (0) | 2022.01.19 |

|---|---|

| Probability (0) | 2022.01.19 |

| Gradient Descent (0) | 2022.01.18 |

| Matrix (0) | 2022.01.17 |

| Vector (0) | 2022.01.17 |